跨过L3/L4技术门槛,车企需要怎样的智能感知芯片?

如今,智能化程度越来越能够决定一台车的价格和热销程度,智能化已经是汽车行业的核心趋势。相关数据显示,2022年L2级智能驾驶渗透率已提升至38%,预计到2025年渗透率会超过60%,且随着利好政策的相继出台,以及主流车企的陆续发力,智能驾驶正由L2向L3甚至更高阶的L4跨越。

2022年11月2日,工信部会同公安部公开《关于开展智能网联汽车准入和上路通行试点工作的通知》征求意见稿,《通知》特别提到智能网联汽车搭载的自动驾驶功能是指国家标准《汽车驾驶自动化分级》(GB/T40429-2-21)定义的3级驾驶自动化(有条件自动驾驶)和4级驾驶自动化(高度自动驾驶)功能(也就是我们常说的L3与L4),《通知》将加速我国L3/L4自动驾驶的落地速度。

与此同时,国际车企也在争先恐后推进相关进程,德国奔驰今年2月在美国加州开了一场110分钟的发布会,主题便是“L4自动驾驶,2024年见!”

可以预见的是,自动驾驶即将加速向更高级别迈进。而聚焦当下,车企以及技术供应商们面临的更关键问题是,如何迈过L3/L4的相关技术门槛?

感知系统是关键一环,4D毫米波雷达备受青睐

在汽车智能化发展过程中,感知系统是至关重要的一环,自动驾驶系统需要全天候、全覆盖、全目标、全工况的感知。尤其L2及以上的智能驾驶,必须构建多个感知维度的目标及环境探测系统,有效融合各种传感器的优势,为车辆的规划控制提供准确有效的信息。

而在多传感器的感知维度里,视觉与毫米波雷达通常被认为是不可或缺的两种传感器,它们之间的感知优势互补性非常强,合理搭配“1+1>2”的效果非常明显。

要知道,即便是此前一直坚持纯视觉路线的特斯拉,也被爆在其最新的自动驾驶硬件HW4.0中加回了毫米波雷达,而且是高分辨率的4D毫米波雷达。

事实上,在此之前,4D毫米波雷达市场关注度便已不断上升。

究其原因,4D毫米波成像雷达,可检测物体的方位、距离、速度、高度等数据。同时,4D成像毫米波雷达具有像素级的角分辨率,可以分辨目标物体的轮廓,经过深度学习,4D雷达还可以区分行人、自行车、汽车、卡车等不同目标。4D成像雷达可以实现多传感器的前融合和点云融合,从而降低漏检率、误报率等。

而值得注意的是,随着毫米波雷达系统射频收发通道数的增多,传统的处理器无法满足毫米波雷达系统大吞吐量数据的计算需求,因此迫切需要设计符合大阵列大吞吐量的雷达专用处理器芯片,近年来海外多家公司都在设计相关的雷达专用处理器。

作为一家在上海张江“中国硅谷”成立的提供智能感知芯片及系统解决方案的半导体设计公司,上海昱感微电子科技有限公司(以下简称“昱感微”)也是该领域的重要玩家之一。

资料显示,昱感微的核心员工全部来自全球顶尖的半导体企业,公司成立不久就获得张江人才港“最具潜力的海归创业团队”大奖。该公司定位在“感知智能”领域,产品目标是帮助客户“多维度高效获取物理世界信息”,为客户提供全球领先的感知技术。

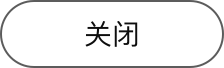

据悉,昱感微电子目前正在研发的4D成像毫米波雷达处理器芯片支持多片射频前端MMIC(四片级联: 16发16收信号通道)高性能4D毫米波感知,或分布式集总架构;其中完全自主知识产权雷达信号处理单元(硬件加速器)信号处理能力强,能耗比高,简化客户开发。

具体来看,其产品特点包括:模块化高度可扩展架构,高效L1/L2/DDR 数据流,兼容CPLX/REAL计算引擎;通用DDMA以及超分辨硬加速,支持检测/DOA交互式先进算法,32bit 高SNR FFT算子,软件定义LRR/MRR/SRR;独创的BIG.little多线程架构,支持实时低延迟感知。

按照昱感微的说法,其4D成像毫米波雷达处理器芯片,可以协助客户降低成本,降低功耗,同时产品的4D雷达点云密度更高,反应更快,探测距离更远。

还有非常重要的一点是:由于4D毫米波成像雷达目前发展非常快,各种先进的算法都正在引入4D成像雷达产品中,对于雷达处理器芯片而言,芯片的架构就必须要能够支持到客户软件差异化实现的需求。针对此,昱感微在其4D成像毫米波雷达处理器芯片的架构设计与实现上也是下足功夫,其雷达处理器芯片在硬件优化(硬件加速器/硬件算子)实现的同时还可保持软件与算法的高度可扩展性,能够支持客户各种先进的雷达算法在芯片内的高效实现。

传感器融合方式升级,智能感知芯片再进化

4D毫米波雷达的火热,也带出了“视觉+毫米波雷达"数据融合方式的新变化。正如前文所说,4D成像雷达可以实现多传感器的前融合。

据悉,特斯拉新发布的HW4.0,并非简单地把雷达传感器加了回来,特斯拉也同时改进了摄像头与毫米波雷达的数据融合方式,由以前发生问题的“传感器后融合”方式进化到“传感器混合式融合”架构。这个系统架构的改进也是特斯拉把毫米波雷达重新加回到系统的另一个原因。

而即便抛开特斯拉的方案不谈,此前业界对于多传感器融合的方式也已有预测:随着各种传感器感知性能的提升,多传感器融合的方式会从简单的结果比对“传感器后融合”方式向“传感器混合式融合”以及“传感器前融合”演进,最终都会进化到“传感器前融合”架构。

只不过,要实现这样的演进并不简单。据了解,“传感器前融合”的感知系统,系统不光要对不同传感器感知信号处理过程做交叉互动来提高有效信息的获取量以及提取质量,系统还要在各传感器捕获目标原始数据的过程就开始互动,系统需要准确地针对感知目标来获取对应的有效信息,这也是AI系统里常常提到的“智能感知“。

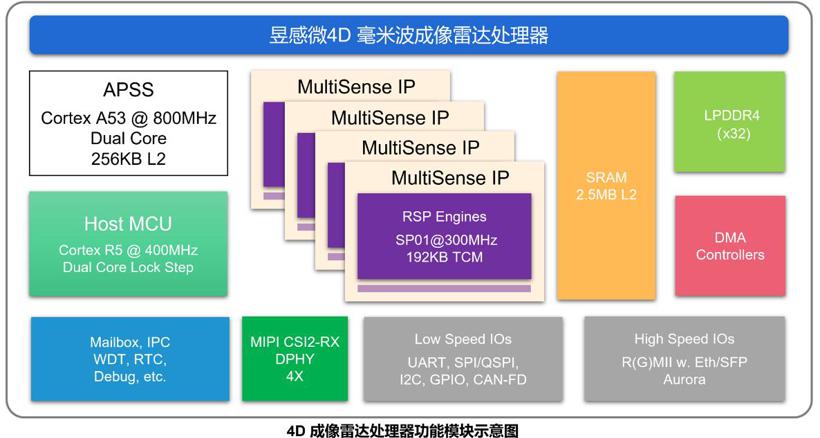

昱感微第一代芯片的第二款产品-多传感器多维像素融合感知芯片,就是针对多传感器前融合的客户需求而设计的,其芯片及系统的架构示意图如下:

据企业官方资料,这一多传感器多维像素融合感知芯片在4D成像毫米波雷达处理器芯片基础上又增加了以下部分:1)对来自摄像头的图像数据做处理的视觉处理子系统(包含支持摄像头传感器的特定曝光控制等功能);2)对多种传感器的目标捕获信息做交互数据挖掘以提高目标探测精准度的交互数据处理系统;3)对多传感器感知数据做高效数据组合并输出的多维像素生成系统。

据称,昱感微的多传感器多维像素融合感知芯片可以帮助客户实现多传感器原始数据的融合(传感器前融合),对目标和环境的感知可以在传感器系统的边缘侧就能挖掘出更多的信息,数据维度更多,目标探测更精准。

目前行业通用的认知是,多种传感器做感知融合时至少包含有摄像头与毫米波雷达。而当其中一种或多种传感器探测到潜在目标时,昱感微的多传感器多维像素融合感知芯片可以实时地对部分或全部其余传感器的探测参数进行互动实时调整。

具体来看,其可对摄像头的像素级的探测参数进行互动实时调整,互动实时调整中的探测参数包括:曝光区域、曝光时间、对焦距离、图像传感器的信号增益、图像传感器的灵敏度、图像传感器的信噪比、色彩滤波阵列中的任意一种或多种;对雷达的发射和/或接收信号的探测参数或探测数据的筛选进行互动实时调整,互动实时调整中的探测参数包括:捕获视角、目标信号的检测提取参数、信号波形及调制方式、信号频率、信号强度、信号帧率、信号带宽、速度谱中的任意一种或多种,等等;然后芯片再将多种传感器探测到的数据处理好后同步实时输出。

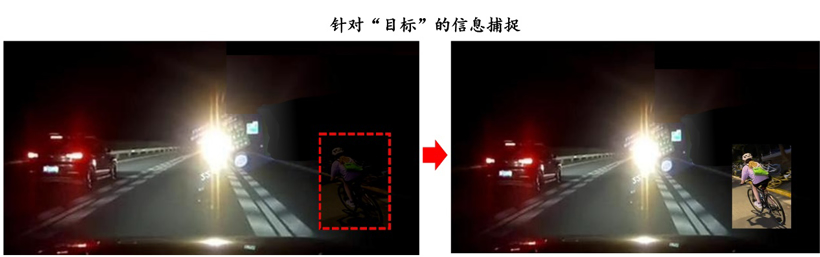

举例来说,当雷达子系统探测到潜在目标时,芯片内运行的软件立刻实时地对摄像头的曝光控制区域进行调整,使其针对目标检测子区域(有运动目标的子区域)进行快速局部曝光,然后对同一时间段内采集的多幅目标检测子区域图像做图像叠加的宽动态处理,融合产生完整的超宽动态图像实时输出。这样,即使在车辆夜间行驶的过程中遇到对面相向而行的车辆开着远光灯干扰本车摄像头系统的挑战场景下,昱感微的多传感器多维像素融合感知芯片仍然可以引导本车的摄像头针对运动目标(可能是在当前图像严重欠曝区域内正在横穿马路的骑车人-非常危险的情况)做快速局部曝光来实时获取运动目标的分辨细节特征,这样的处理就可以防止自动驾驶控制系统出现漏检而撞击目标的情况发生。

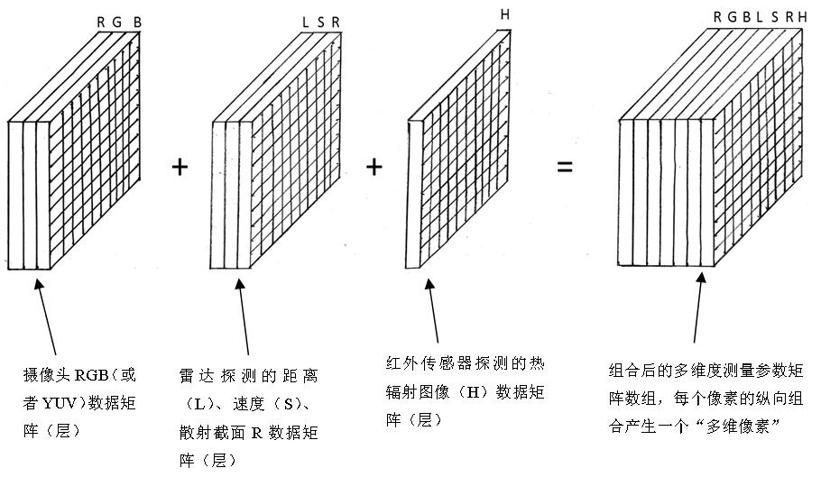

昱感微的多传感器多维像素融合感知芯片将多传感器感知数据做高效数据组合并输出的多维像素的数据格式。

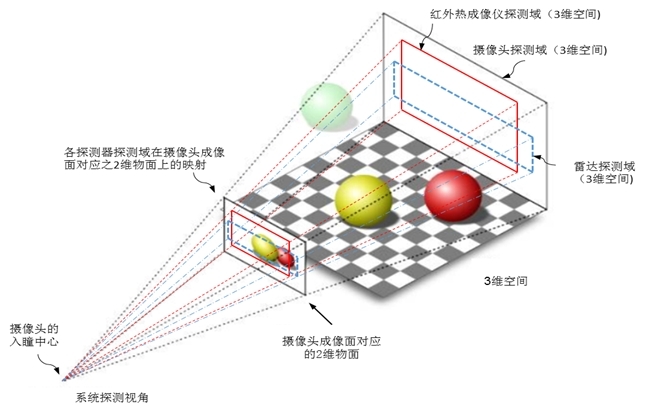

对传感器融合系统而言,各传感器感知数据的“坐标统一,时序对齐”是必须的,同时系统还要做到“数据同质”,并且能够突出“事件感知”(做好针对目标的探测而非笼统的背景探测,同时需要具备对事件是否会发生的预测数据 - 车辆自驾系统对道路上妨碍行驶的障碍物之相对距离与速度的精准探测)。

多传感器组合的探测域空间映射关系示意图

昱感微的多传感器融合处理器芯片把多传感器的目标探测数据用“多维度测量参数”矩阵数组(简称为“多维像素”)的形式组合在一起,建立以摄像头像素为颗粒度的立体多维深度感知;像素除了其原本包含的亮度与颜色信息,还增加了多个维度,如相对距离、相对运动速度、目标的雷达散射截面RCS数据以及目标的热辐射温度分布等数据,目标检测算法基于多维像素矩阵结构,可充分利用信息的融合做深度环境感知。

“多维度测量参数”矩阵数组结构示意图

多维像素这样的数据结构是非常高效的感知信息数据组合方式,不仅直接体现了:坐标统一,时序对齐,数据同质,由于多维像素包含了目标及环境的多个物理维度探测的实时信息(目标的距离、相对速度等信息),它也能够很好地突出:“事件感知”的能力,包含能够预测事件发生的能力;同时,多维像素数据来自多种(不同种类的)传感器的感知数据组合,多维像素数据本身就包含了:异构冗余、多重校验,交互感知,超维耦合,感存一体。这些是都是我们对高效可靠的传感器感知系统的必须要求(满足高质量自动驾驶的必要条件)。

多传感器多维像素组合可以包含的目标与环境感知信息量非常大。举例来说,把视觉图像与毫米波无线检测信号直接对接组合,由于毫米波无线探测在毫米波(77Ghz对应4mm的无线电波波长),无线电波是有绕射及多径穿透能力的,这样的“图像+毫米波”组合的多维像素,在前面有一辆车的探测场景下,在前车这个“多维像素宏块”上可以再包含前前车(被前面这辆车挡住摄像头视野的再前面的一辆车)的存在(有距离、相对速度、RCS)信息,以及可以感知前前一辆车的突发急刹车事件,系统可以预防这样的事故发生!

昱感微指出,多传感器多维像素的组合,就像是我们人对目标与环境的感知,我们以人眼视觉为主体,同时我们每个人都有天然的“脑机接口”,我们会在视觉的基础上把其它感觉(听觉,嗅觉…)都组合在视觉图像里,然后希望具备第六感(预感事件的发生)。昱感微电子的多传感器多维像素融合感知芯片也希望可以助力到AI感知系统相同的功能。

多维像素是在以图像像素为基础的模型上再增加了其它维度(目标的距离、速度等)感知信息,多维像素使得目前的AI处理器都可以复用已有的图像数据集,免除新产品的训练数据需要全部重新采集的困扰,对于目前流行的神经网络框架只需要做很小的修改就可直接适配昱感微电子的芯片输出的“多维像素”,而且神经网络的训练收敛效率以及目标识别准确率都会因为使用了多维像素而有效提升。多维像素的产品落地非常直接简单,不会是因为新的数据结构而给应用推广产品化带来困扰。

特斯拉目前在感知方面的一个重点技术是Occupancy Network (占据网络)。研究机器人技术的同学肯定对occupancy grid不会陌生,occupancy grid表示空间中每个3D体素(voxel)是否被占据,可以是0/1二元表示,也可以是[0, 1]之间的一个概率值。

为什么估计occupancy对自动驾驶感知很重要呢?因为在行驶中,除了常见障碍物如车辆、行人,我们可以通过3D物体检测的方式来估计他们的位置和大小,还有更多长尾的障碍物也会对行驶产生重要影响。例如:1.可变形的障碍物,如两节的挂车,不适合用3D bounding box来表示;2.异形障碍物,如翻倒的车辆,3D姿态估计会失效;3.不在已知类别中的障碍物,如路上的石子、垃圾等,无法进行分类。大家都希望能找到更好的表达来描述这些长尾障碍物,完整估计3D空间中每一个位置的占据情况(occupancy),还要包含语义(semantics)和运动状态(flow)信息。特斯拉希望利用基于“视觉”的占用网络算法, 将感知空间划分为一个个立体网格,通过检测网格是否被占用,实现对物体体积的测算-包括探测到让全世界智能驾驶团队头疼的各类异形物体。

在昱感微看来,真正的自动驾驶面临的道路状况千变万化,自动驾驶要求开发者回到智能的“第一性原理”——从感知和决策的角度先感知周围环境,再根据感知预测其他车辆的运行轨迹,作出自动驾驶车辆的行为规划和决策,完成系统级开发。

“如果自动驾驶系统的算法完全基于深度学习(Deep Learning),就无法解决这种深度神经网络可能带来的‘黑盒’问题:即无法确定系统是根据什么作出决策的-它自己也不知道,因此就无法实现人为预先干预;这样的自动驾驶系统是无法支撑L3及以上的自动驾驶要求的,一台车在地球上可能遭遇的驾驶场景永远会比一个系统接受训练时的数据更丰富,以深度学习为底层算法的系统如何应对复杂长尾场景是让人担心的。”

而昱感微的多传感器多维像素融合感知芯片的“多维像素”数据输出直接具备了目标与环境在3维立体空间所处的物理维度探测信息-感知周围环境与目标的各维度所需物理量,直接提供给系统做高效和精准的决策与执行,避免系统仍需借助大算力“推演”出目标感知数据再做决策执行的潜在问题。

总而言之,昱感微所研发的全新一代智能感知芯片将助力车企跨越L3/L4级智能驾驶感知技术门槛。

来源:盖世汽车

作者:Mina

本文地址:

以上内容转载自盖世汽车,目的在于传播更多信息,转载内容并不代表第一电动网(www.d1ev.com)立场。

文中图片源自互联网,如有侵权请联系admin@d1ev.com删除。